Надежды, которые не сбылись: раньше ИИ не хватало технологий, а сейчас — креатива

На Дартмутском семинаре 1954 года ученые думали, что создадут совершенный ИИ за три года, — и провалились. А сегодня новости о новых нейронках появляются каждый день и все говорят, что будущее уже здесь. Как мы дошли до такой жизни, рассказал на конференции Conversations 2021 CEO EORA Роман Доронин.

Highload послушали и принесли вам с пылу с жару текстовую версию его выступления.

Далее со слов Романа Доронина

____________

На недавней конференции GTC November 2021 исполнительный директор NVIDIA Дженсен Хуанг заявил, что уже в ближайшем будущем вокруг нас будет много роботов, которые будут помогать нам с повседневными делами. Кто-то из них будет виртуальным, кто-то — физическим.

Благодаря computer vision, анимации, искусственному интеллекту и пониманию языка все это возможно уже сейчас. Но как именно от мечты про ИИ в 1950-х мы добежали к тому, что у нас есть?

Давайте посмотрим историю развития ИИ на примере Conversational AI — то есть голосовых ассистентов.

Эра больших надежд

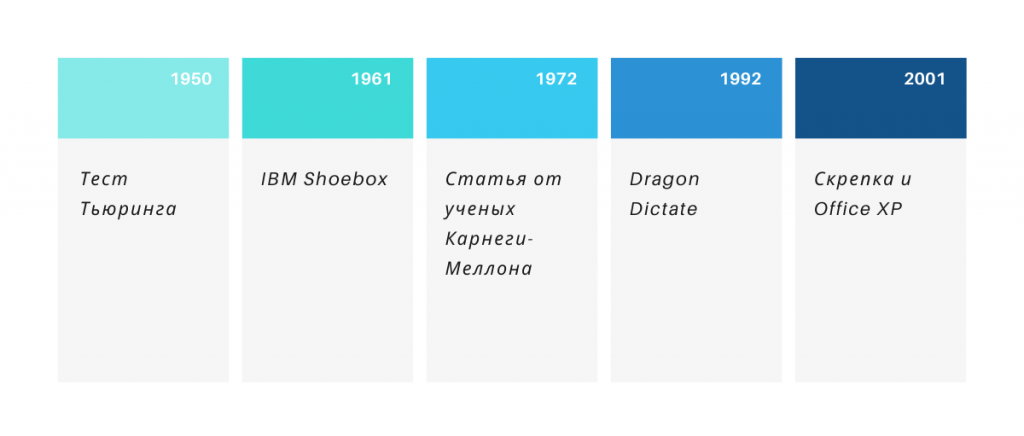

Вернемся в 1950-й, когда появился тест Тьюринга и открыл вселенную Conversational AI, потому что задал вопрос: «Может ли машина быть умнее человека?». С того момента ключевой задачей математики в этой области стало распознавание речи.

Реализовать ее решение удалось только в 1961 году. IBM выпустил Shoebox — систему, которая умела распознавать 16 слов, включая числа от 0 до 9 и такие команды, как «плюс», «минус» и «сумма».

На презентации IBM Shoebox создатель системы Уильям Дерш продемонстрировал, как она понимает, какие числа ей называют, и может их правильно сложить.

Обратите внимание, сколько времени прошло с теста Тьюринга до Shoebox — 11 лет (!). Для следующего прорыва понадобилось столько же: только в 1972 году исследователи университета Карнеги-Меллона описали программу, которая могла распознавать до 1000 слов.

А первый коммерческий продукт с распознаванием речи — DragonDictate от компании Dragon Systems (сейчас Nuance) вышел только в 1992 году. Он понимал, что ему говорят, только если пользователь делал паузы между словами.

Эра больших надежд закончилась в 2001 году. Ее последние важные события — выход «Скрепки» от Microsoft и последующее добавление функции распознавания речи в Office XP.

Эра больших надежд

Если проанализировать эти пятьдесят лет, становится ясно, почему она называется именно «Эра больших надежд»: казалось, что вот-вот, еще чуть-чуть и секрет ИИ будет раскрыт. В 1954 году на Дартмутском семинаре ученые думали, что создадут компьютерное сознание за три года. Но этого не произошло.

Чего не хватило? Вычислительных систем, данных — всего, что является фундаментом машинного обучения сейчас. И что запустило в 2011-м «большую гонку».

Эра большой гонки

Часть первая

В 2011 Apple выпустил Siri. И это было невероятным прорывом.

Уже через год появился Google Now — возможность гуглить голосом. В 2013 году Microsoft подтянулся и выпустил Cortana. А в 2014 Amazon анонсировал умную колонку Echo с Alexa внутри.

Только посмотрите, как ускорились темпы: за четыре года технологии развились настолько, что можно было не просто распознавать голос, но и слышать и понимать его с другого конца комнаты, не воспринимая лишние шумы.

Пик «эры большой гонки» наступил, когда в Alexa появились инструменты для сторонних разработчиков. В нее стало возможно добавлять новые навыки и уже к концу 2014 году количество этих навыков превысило 10 тысяч.

Часть вторая

В 2016 году гонка ускорилась еще больше: если раньше счет шел на годы, то теперь он начал идти на месяцы:

- Март 2016 — Amazon выпускает бюджетную колонку Echo Dot

- Март 2016 — Google анонсирует ассистента как отдельное приложение

- Август 2016 — Microsoft добавляет голосовое управление в Xbox

- Сентябрь 2016 — Amazon запускает продажи Echo в Германии и Англии, то есть (1) американский рынок пресытился, (2) распознавание речи начало затрагивать и другие языки тоже

- Октябрь 2016 — Samsung включается в гонку и покупает создателей Siri, компанию Viv

- Ноябрь 2016 — Google выпускает сразу и свою умную колонку Google Home, и смартфон с голосовым ассистентом Google Pixel

В 2017 все только нарастало: Samsung выпустил ассистента Bixby, Google начал встраивать голосовое распознавание в телевизоры и другие устройства, а еще добавил возможность распознавания разных голосов — например, разных членов семьи (до шести человек).

Последний пункт — это очень важный момент, потому что это означало, что теперь системы могли менять свое поведение, в зависимости от того, кто с ними разговаривает.

Гонка стала настолько большой, что ее масштабы уже невозможно охватить. В июле 2017 года Amazon выпустил колонку с экраном и Conversational AI вышло за рамки текста и голоса. Стало появляться все больше сценариев интеграции и доступных сред, форм, инструментов для сторонних разработчиков.

Что же будет дальше?

Эра (чего-то еще?)

«Все должно быть интерактивно», — говорит Дженсен Хуанг в своем выступлении на GTC November 2021 и приводит в пример «говорящий киоск» в токийском кафе, работающим на системе NVIDIA Omniverse.

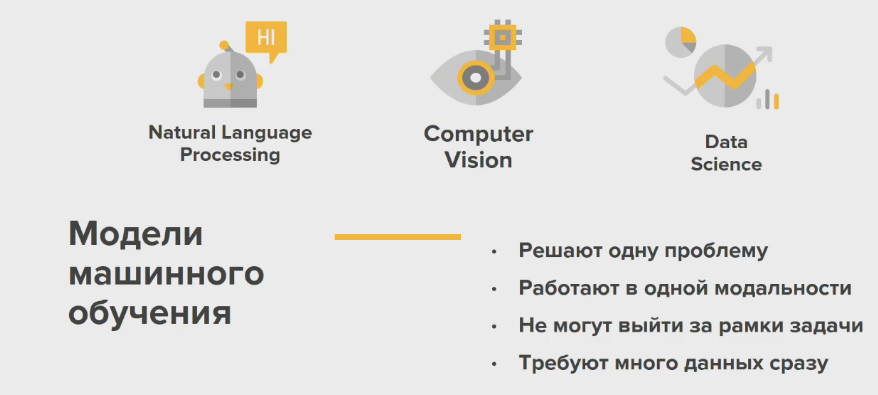

В такой системе есть уже не только распознавание голоса, но и эмпатия и продвинутая графика. Вот каким ИИ был вчера:

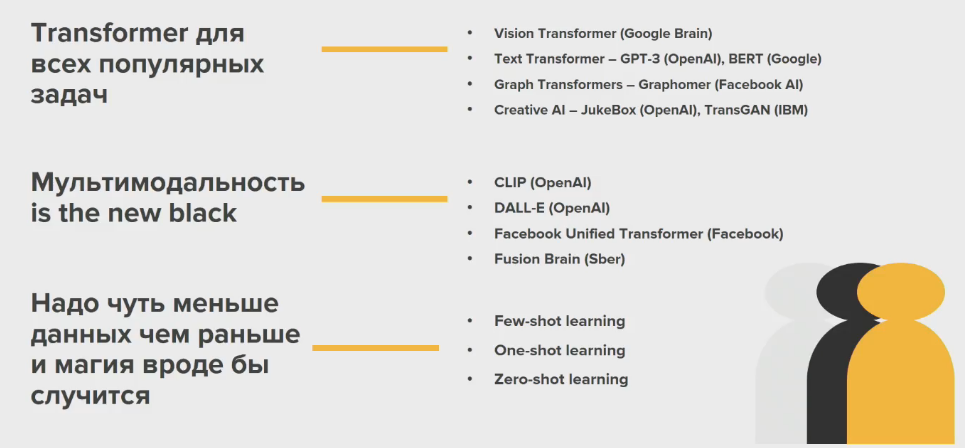

И вот какой он сегодня:

Мой робкий итог: сейчас акцент смещается с ресерча. Количество публикаций о нейронных сетях невозможное. У нас есть мощная технологическая база: новые архитектуры, opensource-инструменты и готовые решения. Наш новый челлендж — разработка пользовательского интерфейса, подходящего для новых интеграций.

Мы должны быть гибкими и изобретательными. Машинное обучение нуждается в людях из креативных индустрий — тех, кто сможет придумать что-то иначе на инструментах, которые у нас уже есть.

Сообщить об опечатке

Текст, который будет отправлен нашим редакторам: